Über bwp@

bwp@ ... ist das Online-Fachjournal für alle an der Berufs- und Wirtschaftspädagogik Interessierten, die schnell, problemlos und kostenlos auf reviewte Inhalte und Diskussionen der Scientific Community zugreifen wollen.

Newsletter

bwp@ 40 - Juli 2021

Didaktisierung des Digitalen: Zur Entwicklung berufs- und wirtschaftspädagogischer Studiengänge

Hrsg.: , , &

Learning Analytics – Didaktischer Benefit zur Verbesserung von Lehr-Lernprozessen? Implikationen aus dem Einsatz von Learning Analytics im Hochschulkontext

Die Zunahme an digitalen Lernsettings führt zu einer Fülle an verfügbaren Daten zu Lehr- Lernprozessen. Gleichzeitig stellt die Interpretation dieser Daten die Akteurinnen und Akteure vor neue Herausforderungen. Learning Analytics umfassen die Aggregation und Interpretation von Lernendendaten mit dem Ziel, Lehr-Lernprozesse zu verbessern. Im Zentrum dieses Beitrages stehen die Implikationen, welche der Einsatz von Learning Analytics im Hochschulkontext mit sich bringt, exemplifiziert anhand der Implementierung in einem konkreten Forschungsprojekt. In einem ersten Schritt erfolgt eine literaturbasierte Aufarbeitung des didaktischen Potenzials aus dem Blickwinkel der Lernenden, Lehrenden sowie des Inhalts und des Learning Designs. Anhand einer qualitativen und quantitativen Begleitforschung eines aktuellen Projektes werden anschließend didaktische Implikationen für den Einsatz von Learning Analytics im Hochschulkontext abgeleitet. Deutlich wird, dass das in der Literatur verortete didaktische Potenzial auch in dieser Implementation zutage tritt, jedoch Learning Analytics gleichzeitig auch erhöhte Anforderungen an Lehrende und Lernende stellt.

Learning Analytics – Didactical Benefit for the Improvement of Teaching and Learning Processes? Implications from the Application of Learning Analytics in a Higher Education Context

Digital data is an inherent by-product of the utilization of digital educational settings with a still widely unclaimed potential. The interpretation of this data imposes new challenges for teachers and learners. Learning Analytics incorporates the aggregation and interpretation of data to improve teaching and learning processes. This paper focuses on the implications of implementation of Learning Analytics in a higher education setting, exemplified by the implementation in a specific research project. Within a first step, the didactical potential of Learning Analytics is drawn from literature with regard of the perspectives of learners, teachers, and content. Based on qualitative and quantitative accompanying study of the implementation of LA, didactical implications are derived for a higher education context. The didactical potential claimed within the literature can also be identified within the underlying implementation of Learning Analytics. However, it also becomes apparent, that Learning Analytics imposes rising challenges for teachers and learners.

1 Einleitung

Das Voranschreiten der digitalen Transformation stößt gesamtgesellschaftliche Entwicklungen an, welche sich auch auf das Bildungssystem erstrecken (vgl. Gloerfeld 2020, 4). Bestehende Berufsfelder und Kompetenzanforderungen verändern sich und erfordern eine proaktive Adaption des Berufsbildungssystems (vgl. Rohs/Seufert 2020, 358). Veränderte Arbeitsabläufe und Geschäftsprozesse in kaufmännischen Berufsfeldern bedingen die Vorbereitung auf Tätigkeitsbereiche einer Verschmelzung von Mensch-und-Maschine. Dies setzt neben wirtschaftlichem auch ein hohes Maß an technologischem Verständnis voraus. Daraus entsteht die Forderung, die berufliche Bildung verstärkt auf „den Umgang mit Prozessen, Daten und Technologien“ (Hmyzo/Muzzu 2020, 100) auszurichten. Die Auswirkungen der Digitalisierung auf das Bildungssystem zeigen sich u. a. in der Entwicklung digitaler Lehr-Lernformen, deren Akzeptanz wiederum Veränderungen auf Ebene etablierter Lehr-Lernkulturen sowie -prozessen bedingt und eine Bereitschaft zur Selbstorganisation inmitten digitaler Bildungsmedien erfordert (vgl. Arnold et al. 2018, 21). Die Möglichkeiten der Digitalisierung in Bildungsbereichen beginnen sich dabei erst auszuformen, denn die Zunahme digitaler Lehr-Lernangebote geht mit einer Zunahme in diesen Kontexten generierter Daten einher. Für die Nutzung dieser Daten, zur Erforschung der Wirkung digitaler Lehr-Lernformen und deren Auswirkungen auf Lehr-Lernprozesse, ist der Rückgriff auf digitale Technologien (u. a. Educational Data Mining, Academic Analytics oder Learning Analytics) naheliegend. Damit erhält Big Data, als Synonym für große unstrukturierte Datenmengen (vgl. Ternès/Hagemes 2018, 149), Einzug in den Bildungskontext und provoziert den Drang, Nutzen aus der Datenflut zu ziehen, sei es auf der Makroebene (Bildungssystem), der Mesoebene (Bildungsmanagement bzw. -institutionen) oder der Mikroebene (Ebene von Lehr-Lernprozessen). Big Data im Hochschulbereich sind beispielsweise Studierendendaten, wie Kursbelegungen, Prüfungsergebnisse oder Daten aus der Nutzung von Bibliotheks- und IT-Diensten und Lernmanagementsystemen (vgl. Lester et al. 2017). Während Big Data-Technologien in wirtschaftlichen Kontexten, beispielsweise zu Marktforschungszwecken, bereits ein breites Anwendungsspektrum bedienen, stecken diese im Bildungssystem noch in einer vergleichsweise frühen Anwendungsphase (vgl. Ifenthaler/Schumacher 2016, 176; Johnson et al. 2013, 5), und fokussieren meist die Auslotung des technisch Möglichen (vgl. Groißböck/Buchner 2016). Der Verknüpfung des technisch Möglichen mit dem pädagogisch Sinnvollen widmet sich das interdisziplinäre Forschungsprojekt Learning Analytics: Auswirkungen von Datenanalysen auf den Lernerfolg (unter Beteiligung der Universität Graz und der Technischen Universität Graz). In diesem Beitrag wird ein Teilbereich des Forschungsprojektes vorgestellt, in welchem Learning Analytics – eine Bildungstechnologie mit originär pädagogischer Ausrichtung – praktische Anwendung im Studium der Wirtschaftspädagogik findet. Die Zielsetzung in diesem Beitrag richtet sich auf die Auslotung des didaktischen Potenzials von Learning Analytics zur individuellen Förderung von Lernprozessen im gegenständlichen Anwendungsszenario.

1.1 Problemstellung

Die fortschreitende Digitalisierung eröffnet die Möglichkeit, immer mehr Daten aus der Nutzung digitaler Lehr-Lernarrangements zu sammeln, speichern und zu verarbeiten (vgl. Gloerfeld 2020, 18). Eine rein datengetriebene und technisch orientierte Sichtweise auf Veränderungsprozesse aus dem Titel der Digitalisierung greift aus berufs- und wirtschaftspädagogischem Blickwinkel zu kurz. Die diesbezügliche Diskussion richtet sich u. a. auf die Notwendigkeit der dementsprechenden Anpassung von Lehr-Lerninhalten und Modifikation der Lehrer/innen/bildung. Darüber hinaus werden Fragestellungen zur Forcierung lebenslangen Lernens im Kontext der digitalen Transformation mit den damit verbundenen Voraussetzungen adressiert (vgl. Ostendorf 2019, 1; Dubs 2009, 49). In diesem Zusammenhang werden veränderte Kompetenzanforderungen im Beschäftigungs- und Bildungsbereich debattiert. Hieraus ergibt sich die Forderung nach einer digital integrierten didaktischen Betrachtung des Einsatzes digitaler Technologien im beruflichen Lernen. Der Fokus liegt dabei auf der digital gestützten Entwicklung und Förderung beruflicher Handlungsfähigkeit (vgl. Euler/Wilbers 2020, 427, 437; Gerholz/Dorman 2017, 2). In Hinblick auf diesbezüglich notwendige Kompetenzerfordernisse rücken damit die Entwicklung beruflicher Medienkompetenz bzw. die Ergründung medienpädagogischer Erfordernisse für die Lehrer/innen/bildung in den Vordergrund (vgl. Rohs/Seufert 2020, 358; Mandausch/Meinhard 2018, 30). Abgesehen von Medienkompetenz bedingt der Umgang mit der digitalen Transformation eine zunehmende Ausrichtung auf die Förderung von Digital Literacy und Data Literacy auf Ebene der Lernenden und Lehrenden (vgl. Grillenberger/Romeike 2019, 6; Janschitz et al. 2019). Kurzum: durch die Digitalisierung ausgelöste Veränderungsprozesse bedingen die Entwicklung digitaler Handlungskompetenz, welche begrifflich alle damit verbundenen Kompetenzrelationen einschließt. Zur Ausformung digitaler Handlungskompetenz führt allerdings kein Weg an der Nutzung digitaler Technologien vorbei. Ein weiterer Schritt – neben der Anwendung von Technologien – besteht in der gleichzeitigen Nutzung einhergehender Nebenprodukte: Daten. Daten, die aus der Nutzung digitaler Technologien im Lehr-Lernkontext entstehen, und welche damit wiederum Aufschluss über Lehr-Lernprozesse geben können und in weiterer Folge die (digitale) Kompetenzentwicklung (zeitnah) vorantreiben können. Eine berufs- und wirtschaftspädagogische Auseinandersetzung mit dem Datenpotenzial für deren Handlungsfelder in Forschung und Praxis scheint aus diesem Gesichtspunkt unerlässlich.

Dieser Beitrag bewegt sich in dem Spannungsfeld, die Potenziale der Digitalisierung im Bereich der Datennutzung aufzuzeigen, ohne die berufs- und wirtschaftspädagogischen Anforderungen der Weiterentwicklung beruflicher Lehr-Lernprozesse zu negieren. Dazu werden digitale Technologien als Lerninstrument für die Optimierung beruflicher Lehr-Lernprozesse betrachtet, die in die drei Bereiche (1) Präsentationsmedien, (2) Kommunikationsmedien und (3) Selbstlernmedien klassifiziert werden können. Im Fokus des gegenständlichen Beitrages steht insbesondere die Kategorie der Selbstlernmedien, zu welchen auch Learning Analytics zugerechnet werden (vgl. Euler/Wilbers 2020, 427f., 432f.; Euler/Seufert/Wilbers 2006, 437). Lernende hinterlassen in digitalen Lernumgebungen eine Vielzahl an Datenspuren. Learning Analytics verfolgen die Zielsetzung, diese Datenspuren verwertbar zu machen, indem diese in konstruktiv nutzbare Informationen zur Verbesserung von Lehr-Lernprozessen transformiert werden sollen (vgl. Ebner/Ebner 2018, 5-6; Ifenthaler/Widanapathirana 2014, 222). Dadurch können Lernprozesse individuell unterstützt werden, was sich in weiterer Folge positiv auf die Employability der Lernenden auswirken kann (vgl. Seiler et al. 2018, 598).

1.2 Einführung in das Projekt und Fokus der Darstellung

Die Implementierung von Learning Analytics im Bildungsbereich ist bis dato eher technisch orientiert (vgl. Groißböck/Buchner 2016) und selbst hier noch sehr im Forschungsbereich verhaftet (vgl. Leitner/Khalil/Ebner 2017). Die pädagogische bzw. didaktische Betrachtungsebene wird zwar als relevant erachtet (vgl. Ebner et al. 2015, 2; Wise 2014, 209), hat jedoch noch unzureichend Eingang in Forschungsarbeiten gefunden (vgl. Seufert et al. 2019, 599; Koh/Choi 2016, 10). Im gegenständlichen Beitrag wird Learning Analytics für die didaktische Gestaltungsebene greifbar gemacht, indem Erkenntnisse aus einem laufenden Forschungsprojekt skizziert werden. Die Betrachtung der didaktischen Dimension ist dabei nur ein Teil des vom Zukunftsfonds Steiermark geförderten Projektes Learning Analytics – Auswirkungen von Datenanalysen auf den Lernerfolg.

seit Jänner 2020 widmet sich ein interdisziplinäres Team unter Beteiligung der Universität Graz (Zentrum für digitales Lehren und Lernen sowie Institut für Wirtschaftspädagogik) und der Technischen Universität Graz (Lehr- und Lerntechnologien) der bis dato im deutschsprachigen Raum noch wenig ausgeprägten (vgl. Büching et al. 2019) praktischen Erfahrungen mit Learning Analytics. Um dieses Defizit auszugleichen, werden Learning-Analytics-Anwendungen in zwei heterogenen Lehrveranstaltungen implementiert und entlang von drei Analysedimensionen (technisch, pädagogisch-didaktisch, rechtlich-ethisch) erforscht, um über die Heterogenität Gemeinsamkeiten in diesen Dimensionen ausfindig zu machen. Das Projekt adressiert dabei das Erkenntnisinteresse, welche Formen von Learning Analytics mit dem Lernmanagementsystem Moodle (technisch) durchführbar sind, welche didaktischen Implikationen daraus abgeleitet werden können und wie sich diese auf den Lernerfolg auswirken sowie welchen Einfluss rechtliche und ethische Rahmenbedingungen auf die Datenerfassung und -analyse haben.

Eine der beiden im Rahmen des Projektes beforschten Lehrveranstaltungen stellt eine fachdidaktische Lehrveranstaltung im Masterstudium der Wirtschaftspädagogik an der Universität in Graz dar, die im Sinne des Konstruktivismus Interaktions- und Kollaborationsprozesse in den Vordergrund stellt. Ursprünglich als Blended-Learning-Szenario geplant, wurde die Lehrveranstaltung aufgrund der COVID-19 Pandemie in einem Distance-Learning-Modus durchgeführt. Die zweite beforschte Lehrveranstaltung stellt ein von der Technischen Universität Graz konzipierter Massive Open Online Course (MOOC) für Lehramtsstudierende dar, wo Lerninhalte für eine große Anzahl an Kursteilnehmer/innen vor allem in Form von Videos und Self-Assessments zur Verfügung gestellt werden.

Innerhalb der zweieinhalbjährigen Projektlaufzeit werden beide Lehrveranstaltungen in drei aufeinanderfolgenden Semestern (t1, t2, t3) als exemplarische Use-Cases für die Analyse des Potentials von Learning Analytics herangezogen. Der Fokus des ersten Semesters liegt auf einer Deskription der Daten, welche im Lernmanagementsystem aus technischer Perspektive überhaupt generiert werden können. Im zweiten Semester erhalten die Lernenden auf Basis der von ihnen im Lernmanagementsystem erzeugten Daten unmittelbare Rückmeldungen über ihr Lernverhalten. Im abschließenden dritten Semester werden Studierende mit Informationen aus den Datenanalysen der ersten beiden Semester versorgt, mit dem Ziel, sie mit förderlichem und hinderlichem Lernverhalten im Lernmanagementsystem vertraut zu machen, noch bevor sie selbst mit den Lerninhalten arbeiten.

Im Rahmen dieses Beitrags erfolgt der Fokus auf die Implementierung von Learning Analytics in den ersten zwei Erhebungsperioden des Projektes (t1, t2) in einer fachdidaktischen Lehrveranstaltung des Masterstudiums Wirtschaftspädagogik an der Universität Graz. Der Schwerpunkt liegt auf der Darstellung des didaktischen Potenzials zur individuellen Förderung von Lernprozessen durch Einsatz von Learning Analytics im konkreten Anwendungsszenario.

1.3 Disposition

Um das Forschungsfeld Learning Analytics und dessen Einsatzmöglichkeiten sowie didaktisches Potenzial zu erfassen, erfolgt in Kapitel 2 eine einleitende Skizzierung des Forschungsfeldes. Neben der Definition und Abgrenzung werden die vielfältigen Ziele und Formen von Learning Analytics erläutert, um einen Einblick auf das umfassende Anwendungsspektrum von Learning Analytics zu geben. Das Kapitel schließt mit einer kurzen Darstellung des Learning-Analytics-Prozesses, um die Vorgehensweise der Anwendung von Learning Analytics zu illustrieren. Anschließend wird in Kapitel 3 Learning Analytics aus didaktischem Blickwinkel betrachtet. Dazu dient als Referenzrahmen ein didaktisches Learning-Analytics-Dreieck, anhand dessen Betrachtungsebenen das theoretisch mögliche didaktische Potenzial von Learning Analytics abgeleitet wird. Dieses im Kapitel 3 kategorisierte didaktische Potenzial bildet zugleich den Ausgangspunkt zum Abgleich des didaktischen Potenzials im konkreten Anwendungsszenario. Hierfür erfolgt in Kapitel 4 zunächst die Kurzdarstellung der Implementierung von Learning Analytics, gefolgt von der Beschreibung des methodischen Vorgehens im vorgestellten Projekt. Das entwickelte kombiniert quantitativ und qualitative Forschungsdesign dient zur Auslotung des didaktischen Potenzials von Learning Analytics, um individuelle Lernprozesse zu fördern. Im Anschluss werden das im dritten Kapitel skizzierte theoretisch mögliche didaktische Potenzial sowie das sich im konkreten Anwendungsszenario gezeigte Potenzial kontrastiert und es erfolgt eine Darlegung der vorläufigen Ergebnisse aus dem Projekt mit Ableitung didaktischer Implikationen. Der Beitrag endet mit einer abschließenden Darstellung und einem Ausblick.

2 Learning Analytics – Einführung, Zielsetzung und Prozess

Zur Annäherung an das Forschungs- und Anwendungsgebiet der Learning Analytics erfolgt zunächst die Definition und damit Abgrenzung von Learning Analytics zu verwandten Disziplinen des Educational Data Mining und Academic Analytics. Die originär pädagogische Ausrichtung von Learning Analytics wird durch deren Ziele und Ausprägungsformen unterstrichen. Der abschließend dargestellte Learning-Analytics-Prozesses illustriert die Vorgehensweise bei Anwendung von Learning Analytics. Diese allgemein gehaltenen Ausführungen dienen einerseits zur Einführung in das Themenfeld Learning Analytics und andererseits, um den Bedeutungszuwachs von Learning Analytics für den Bildungskontext erfassen zu können.

2.1 Definition und Abgrenzung des Forschungsfeldes

Learning Analytics stellen ein interdisziplinäres Forschungsfeld an der Schnittstelle zu Lehr-Lernforschung, (Bildungs-)Informatik und Statistik dar (vgl. Ifenthaler/Schumacher 2016, 176). Im Zentrum der für das Forschungsfeld basisbildenden Definition nach Siemens (2013) steht die Optimierung von Lehr-Lernprozessen: „Learning analytics is the measurement, collection, analysis and reporting of data about learners and their contexts, for purposes of understanding and optimizing learning and the environments in which it occurs.“ (Siemens 2013, 1382) Mit Learning Analytics werden demnach maschinell auswertbare Daten von Lernenden und deren Lernverhalten in technologiegestützten Lernumgebungen gesammelt, in Echtzeit analysiert und visualisiert. Die hierdurch generierten Einsichten in Lehr-Lernprozesse sollen genutzt werden, um diese wiederum zu verbessern (vgl. Höfler/Kopp 2018, 560; Ifenthaler/Schumacher 2016, 176f.). Learning Analytics intendieren damit die Unterstützung und Optimierung des Lehrens und Lernens (vgl. Leitner et al. 2019, 4), und adressieren infolgedessen potenziell sowohl Lehrende als auch Lernende:

- Lernende erfahren Unterstützung durch beispielsweise Lernmaterialien, die ihrem individuellen Leistungsstand entsprechen. In Kombination mit einem möglichen Aufzeigen erfolgreicher Lernpfade oder dem Vergleich mit Lernaktivitäten von Peers können Learning Analytics weiters Reflexionsimpulse setzen und selbstgesteuertes Lernen unterstützen (vgl. Ifenthaler/Schumacher 2016, 177; Chatti et al. 2012b, 22).

- Lehrenden wird mit Learning Analytics eine Echtzeitbetrachtung ihrer Lehre ermöglicht. Das Aufzeigen tatsächlich genutzter Lern- und Betreuungsaktivitäten schafft Reflexionsanlässe und kann die bedarfsgerechte Adaption des Lehrhandelns begünstigen (vgl. Ifenthaler/Schumacher 2016, 176; Johnson/Adams/Cummins 2012, 26).

Demnach sollen Daten digitaler Lehr-Lernprozesse, durch die Überführung in pädagogisch verwertbare Informationen, wiederum zur Verbesserung von Lehr-Lernprozessen eingesetzt werden (vgl. Ebner/Ebner 2018, 5f.; Grandl et al. 2017, 1). Learning Analytics liefern dahingehend Instrumente zur Anreicherung des pädagogischen Handelns. Die Herausforderung liegt dabei jedoch darin, die zur Verfügung gestellten Daten überhaupt in einen pädagogisch sinnvollen Kontext übersetzen zu können (vgl. Lockyer/Heathcote/Dawson 2013, 1455). Hier ist nach wie vor die Expertise von Lehrenden gefragt (vgl. Ebner/Neuhold/Schön 2013, 5).

In Bezug auf die Nutzung von Daten des Bildungskontextes werden vor allem die Konzepte des Educational Data Mining, Academic Analytics und Learning Analytics diskutiert, deren gemeinsames Ziel eine datengestützte Verbesserung von Lehr-Lernprozessen ist. Während Educational Data Mining automatisationsgestützt Informationen aus sämtlich verfügbaren Daten des Bildungskontextes aufbereitetet (vgl. Bienkowski/Feng/Means 2014, 8; Siemens/Baker 2012), befasst sich Academic Analytics mit der datengestützten Optimierung von Bildungseinrichtungen aus einem politischen, wirtschaftlichen und organisationalen Blickwinkel (vgl. Romero/Ventura 2020, 2; Chatti et al. 2012a, 319; Ferguson 2012, 310; Long/Siemens 2011, 34). Learning Analytics hingegen haben sich der Ebene digitaler Lehr-Lernprozesse verschrieben, indem Daten von Lernenden zugunsten von Lernenden eingesetzt werden sollen (vgl. Mandausch/Meinhard 2018, 24ff.; Leitner et al. 2019, 8).

2.2 Ziele und Formen von Learning Analytics

Die Implementierung von Learning Analytics verspricht eine Verbesserung der Lehr-Lernqualität durch Entwicklung eines vertieften Verständnisses für Lehr-Lernprozesse. Die mit Learning-Analytics-Anwendungen verfolgten Ziele sind u. a. (vgl. Grandl et al. 2017, 5f.; Verbert et al. 2012, 138; Chatti et al. 2012a, 9f.):

- Prognose erwarteter Lernerfolge wie Lernfortschritte oder Lernergebnisse

- Personalisierung von Lernumgebungen

- Abgabe von Feedback und Empfehlungen relevanter nächster Lernschritte und Lernmaterialien

- Darlegung erfolgreicher Strategien und Methoden zur Erreichung von Lernergebnissen

- Förderung der Reflexionsfähigkeit und Bewusstsein über Lehr-Lernprozesse

- Unterstützung des sozialen Lernens

- Identifizierung des Lernstandes, eines nachteiligen Lernverhaltens und Lernschwierigkeiten

- Erfassung der Gefühlsage der Lernenden zur Anpassung von Lernstrategien

Diese Zielsetzungen zeigen das Potenzial des Einsatzes von Learning Analytics für die Weiterentwicklung von Lehr-Lernprozessen. Ist die Diagnose von Lernprozessen bis dato von der subjektiven Wahrnehmung der Lehrpersonen abhängig, können Learning Analytics die Möglichkeiten einer diagnostischen Betrachtung erweitern. Die Visualisierung von Lernendenaktivitäten kann beispielsweise der Identifizierung von Lernschwierigkeiten dienen (vgl. Schön/Ebner/Kothmeier 2012). Darüber hinaus wird es Lehrenden ermöglicht, umgehend auf Bedürfnisse der Lernenden eingehen und Lehrmethoden sowie Lernmaterialien zeitnah anpassen zu können. Auch Lernende können unmittelbar einen Nutzen aus Learning Analytics ziehen, indem diese durch Visualisierung ihres Lernstandes und Lernfortschrittes ein Bewusstsein für ihr Lernverhalten entwickeln und so ihre Fähigkeit zu selbstgesteuertem Lernen verbessern können (vgl. Grandl et al. 2017, 6; Buckingham Shum/Ferguson 2012, 4). Die Nutzung von Learning Analytics eröffnen auch Forschenden Möglichkeiten zur Fortentwicklung von Lehr-Lerntechnologien, gegebenenfalls zur Erforschung von Best-Practice-Kursen oder auch zur Weiterentwicklung didaktischer Modelle. Nicht zuletzt zeigen auch Bildungsinstitutionen Interesse an Learning Analytics. Eine Datenanalyse kann beispielsweise Vorhersagewerte über das Risiko eines Studienabbruchs liefern, woraufhin adaptierte Maßnahmen die Drop-Out-Raten vermindern und die Studienabschlussquote erhöhen können (vgl. Grandl et al. 2017, 6; Siemens/Gasevic 2012, 1).

Das Leistungsvermögen von Learning Analytics respektive die Interpretation der Daten hängt dabei von den eingesetzten Tools und Analysemethoden sowie der jeweiligen Zielsetzung ab. Learning Analytics vereinen verschiedene Methoden aus dem qualitativen und dem quantitativen Bereich. Verwendung finden beispielsweise statistische Analysen wie Klassifikations- oder Clusteranalysen, soziale Netzwerkanalysen, Visualisierungen, Vorhersagemodelle oder Textanalysen (vgl. Ray/Saeed 2018, 138f.; Grandl et al. 2017, 7f.; Chatti et al. 2012a, 327f.). Seufert/Guggemos/Sonderegger (2020) unterscheiden folgende drei Formen von Learning Analytics: (1) deskriptive Analytics, (2) prädikative Analytics und (3) präskriptive Analytics. Deskriptive Analytics fokussieren die Effektivität des Lernens durch Analysieren des Nutzungsverhaltens von Lerninhalten, Entschlüsseln von Lernmustern oder Visualisieren von Interaktionen. Prädikative Analytics richten sich auf das Planen von Interventionen, indem z. B. Abweichungen von vorgeschlagenen Lernpfaden oder ein etwaiges Studienabbruchsrisiko frühzeitig identifiziert werden. Die dritte Form von Learning Analytics, präskriptive Analytics, richten sich auf das Setzen von Handlungen in Echtzeit, beispielsweise dem Empfehlen bewährter Lernpfade, dem Ermitteln optimaler Lernstrategien oder dem Adaptieren technologiegestützter Lernumgebungen (vgl. Seufert/Guggemos/Sonderegger 2020, 91).

2.3 Learning-Analytics-Prozess

Lernende generieren während der Nutzung eines Lernmanagementsystems eine Vielzahl von Daten, die in Inhalts- und Metadaten klassifiziert werden können. Während sich Inhaltsdaten auf von Lernenden produzierte oder hochgeladene Elemente beziehen (z. B. Foreneinträge), stellen Metadaten, denen auch Logfiles zugerechnet werden, die beschreibende Komponente dieser digital durchgeführten Aktivitäten dar (vgl. Krause 2020, 69; Trübner/Mühlichen 2019, 144). Dies sind beispielsweise Zugriffsinformationen auf Lernaktivitäten oder Identifikationsdaten wie User-IDs (vgl. Krause 2020, 69; 847Schmitz/Yanenko 2019). Khalil und Ebner (2015) untergliedern derartige Daten von Lernenden in Kommunikationsdaten (u. a. E-Mails, Foreneinträge), Interaktionsdaten mit fester Struktur (u. a. Anzahl von Logins, Up- und Downloads, Social Network Aktivitäten, Logfiles), persönliche Daten (u. a. demografische Daten) und spezifische Lernendendaten je nach Bildungsinstitution (u. a. Prüfungsergebnisse, Informationen zum Bildungsweg) (vgl. Grandl et al. 2017, 7; Khalil/Ebner 2015, 1329). Diese gesammelten Datentypen werden anschließend softwaregestützt ausgewertet (vgl. Ifenthaler/Schumacher 2016, 177).

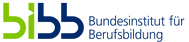

Abbildung 1: Learning-Analytics-Prozess (vgl. Chatti et al. 2012a, 322f.)

Abbildung 1: Learning-Analytics-Prozess (vgl. Chatti et al. 2012a, 322f.)

Der Learning-Analytics-Prozess (Abbildung 1) kann dabei als iterativer Zyklus in den drei Hauptschritten (1) Datensammlung und -aufbereitung, (2) Datenanalyse und -auswertung, (3) Datennachbereitung bzw. -interpretation beschrieben werden:

(1) In der Phase der Datensammlung und -aufbereitung werden Daten (u. a Inhaltsdaten, Metadaten, wie auch übergeordnete soziodemografische Daten oder Prüfungsergebnisse) verschiedenster Datenquellen zusammengetragen und je nach verwendeter Analysemethode aufbereitet (vgl. Krause 2020, 69; Grandl et al. 2017, 12; Chatti et al. 2012a, 322), d. h. beispielsweise bereinigt, transformiert oder verdichtet (vgl. Romero/Ventura 2007, 135).

(2) In der zweiten Phase der Datenanalyse und -auswertung werden, je nach Zielsetzung von Learning Analytics, geeignete Analysemethoden auf die Daten angewendet und deren Auswertungen meist auf Dashboards visualisiert (vgl. Leitner/Ebner 2017; Buckingham Shum/Ferguson 2012, 4). Die Herausforderung liegt dabei u. a. in einer sinnvollen Interpretation der in diesen Dashboards dargestellten Daten, da diese Interpretation die Grundlage weiterer Handlungsschritte, wie z. B. ein Überwachen, Vorhersagen, Intervenieren, Empfehlen, Personalisieren, Anpassen oder Reflektieren, darstellt (vgl. Chatti et al. 2012a, 323).

(3) Die abschließende Nachbereitungsphase dient vor allem der kontinuierlichen Verbesserung von Learning Analytics. Neben der Einbindung zusätzlicher Datenquellen, können Verfeinerungen des Datensatzes und/oder Änderungen der Analysevariablen bzw. ‑methoden vorgenommen werden (vgl. Chatti et al. 2012a, 323).

3 Learning Analytics – Betrachtung aus didaktischer Perspektive

Die Fähigkeit zu selbstreguliertem Lernen wird als wesentliche Voraussetzung für lebenslanges Lernen angesehen und gilt als Zielausrichtung von Bildungsprozessen und didaktischen Bemühungen (vgl. Baumert et al. 2001, 28; Zimmerman 1989, 4). Selbstreguliertes Lernen lässt sich dabei als „zielorientierter Prozess des aktiven und konstruktiven Wissenserwerbs beschreiben, der auf dem reflektierten und gesteuerten Zusammenspiel kognitiver und motivational-emotionaler Ressourcen einer Person beruht“ (Baumert et al. 2001, 28). Dabei befinden sich nicht alle Lernenden auf dem gleichen Lernniveau bzw. Entwicklungsstand (vgl. Groißböck/Buchner 2016). Das Wissen über Lernende respektive die Fähigkeit zur Identifizierung bzw. Diagnose von Lernleistungen (Lernfortschritte, Erfolge, Schwierigkeiten) ist jedoch zentral um Lernende bedarfsgerecht unterstützen zu können. Demnach ist die Diagnosekompetenz eine wesentliche Voraussetzung für die individuelle Betreuung von Lernenden (vgl. Dubs 2009, 68f.).

Ohne Einsatz digitaler Tools liegt die Diagnosekompetenz bei den Lehrenden selbst, d. h. sie beobachten das unterrichtliche Geschehen sowie ihre Lernenden und ziehen daraus Schlüsse (vgl. Vogt 2011, 8). Lernende, die sich dabei aktiv um Unterstützung bemühen, schneiden in Bezug auf ihre Noten tendenziell besser ab (vgl. Ryan/Shin 2011, 247f.). Zurückhaltende Lernende sind demnach vergleichsweise benachteiligt. Neben der Beobachtung sind Kontrollen von Aufgabenstellungen oder Leistungsüberprüfungen eine weitere Diagnosequelle (vgl. Vogt 2011, 8). Es liegt jedoch auf der Hand, dass durch diese traditionellen Praktiken personalisiertes Lernen nicht ausreichend unterstützt werden kann. Mehr Informationen über Lernende liefern eine bessere Ausgangsbasis zur Gestaltung individualisierten Unterrichts (vgl. Groißböck/Buchner 2016; Greller/Drachsler 2012, 53). An dieser Forderung nach individueller Lernunterstützung und personalisierter Lernumgebung setzt die Entwicklung von Technologien, wie Learning Analytics an (vgl. Johnson et al. 2013, 19).

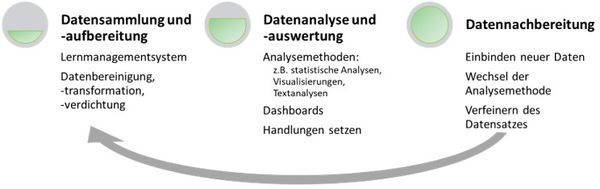

Zur Auslotung des didaktischen Potenzials wird in diesem Beitrag als Referenzrahmen auf das didaktische Dreieck zurückgegriffen, welches das Zusammenwirken grundlegender Elemente des Unterrichts (Lehrende, Lernende und Inhalt) darstellt. Mit Einbeziehung des Einsatzes von Learning Analytics beinhaltet das didaktische Dreieck auch das Learning Design. Der Begriff Learning Design weist hier auf die lernendenzentrierte Orientierung bei der didaktischen Ausgestaltung von technologiegestützten Lernumgebungen hin. Das didaktische Design fokussiert auf „what students do“ (Rienties et al. 2017, 134). Ausgangspunkt eines Learning Designs ist die Perspektive der Lernenden, im Gegensatz zum Instructional Design, bei welchem didaktische Entscheidungen primär auf Seite der Lehrenden beruhen (vgl. Seufert/Euler 2005, 5f.). Learning Design kann dabei als die bestmögliche Passung von Inhalten, Lehre und lernrelevanten Bedürfnissen Lernender betrachtet werden. Das didaktische Learning-Analytics-Dreieck (Abbildung 2) symbolisiert darüber hinaus Learning Analytics als eine Tiefendimension, einem Offenlegen einer bisher verborgenen Perspektive auf die wechselseitig beeinflussenden Elemente von Lehr-Lernprozessen und Lernangebot und ermöglicht damit u. a. die Optimierung des Learning Designs als verbindende Dimension.

Abbildung 2: Didaktisches Learning-Analytics-Dreieck in Anlehnung an Jank/Meyer (2014, 55)

Abbildung 2: Didaktisches Learning-Analytics-Dreieck in Anlehnung an Jank/Meyer (2014, 55)

Das aus der Literatur abgeleitete didaktische Potential von Learning Analytics wird nachfolgend anhand der drei Betrachtungsebenen Lernende, Lehrende sowie Inhalt und der integrativen Betrachtung des Learning Designs dargestellt, wobei keine Unterscheidung zwischen Datenquellen und Datentypen getroffen wird. Wie gezeigt wird, liefern Learning Analytics Ansatzpunkte (in Echtzeit) zur Optimierung und Personalisierung aller drei Betrachtungsebenen.

3.1 Lernende

Für Lernende ergeben sich folgende Potenziale aus der Anwendung von Learning Analytics:

- Transparenz von Lernstand und Lernfortschritt: Das Offenlegen von Daten aus Lernprozessen bietet Lernenden die Möglichkeit, ihr eigenes Lernverhalten zu hinterfragen. Sie haben Gelegenheit, sich Lerngewohnheiten bewusst zu machen, Lernergebnisse zu reflektieren oder auch ihren Lernstand oder Lernwege mit anderen zu vergleichen. Lernstands- und Lernfortschrittsvisualisierungen ermöglichen den Abgleich gesetzter Lernziele mit erreichten Lernfortschritten. Dies trägt weiters zur Unterstützung des selbstgesteuerten Lernens bei (vgl. Mandausch/Meinhard 2018, 29 und 31; Hattie 2018; Ifenthaler/Schumacher 2016, 178ff.; Ifenthaler 2012, 48).

- Echtzeit-Feedback: Feedback stellt unumstritten einen der stärksten Einflussfaktoren erfolgreicher Lernprozesse dar (vgl. Hattie 2018, 131). Hattie unterscheidet vier Ebenen von Feedback, informationsbezogenes und prozessbezogenes Feedback sowie Feedback auf Ebene der Selbstregulation und auf Ebene des Selbst (zu den Ebenen von Feedback vgl. z. B. Hattie 2018, 135ff.). Learning Analytics können dabei Feedback auf drei der vier Ebenen in Echtzeit unterstützen: (1) auf informationsbezogener, (2) prozessbezogener und (3) selbstregulationsbezogener Ebene. Automatisierte Feedbackmechanismen übernehmen dabei die Rolle einer Echtzeit-Unterstützung. Unmittelbar im Anschluss an e-Assessments können Lernende u. a inhaltliches Sofort-Feedback und/oder weiterführende automatisierte Lernhilfen erhalten (vgl. Mandausch/Meinhard 2018, 28; Ifenthaler/Schumacher 2016, 177ff.). Azcona et al. (2019) zeigen beispielsweise auf, dass ein datenbasierendes personalisiertes Feedback das Potenzial hat, Leistungsunterschiede zwischen Lernenden zu minimieren und sich dieses darüber hinaus auch leistungsfördernd auswirken kann (vgl. Azcona/Hsiao/Smeaton 2019).

- Datengestützte Empfehlungen nächster Lernschritte, lernbedarfsgerechter Lernmaterialien oder bereits bewährter Lernpfade und -strategien bieten Lernenden zudem die Möglichkeit, ihre Lernwege zu optimieren und damit auch ihre Lernerfolge zu erhöhen (vgl. Groißböck/Buchner 2016; Chatti et al. 2012b, 22).

Darüber hinaus ergeben sich Potenziale in Hinblick auf Reflexionsimpulse, Peer Learning und selbstreguliertes Lernen: Reflexionsimpulse werden in Bezug auf Lehr-Lernverhalten, Lehr-Lernprozesse oder -aktivitäten gesetzt und zeigen damit Weiterentwicklungsmöglichkeiten auf bzw. dienen als Anstoß zur kontinuierlichen Verbesserung (vgl. Tulodziecki 2020, 376; Mandausch/Meinhard 2018, 25; Grandl et al. 2017, 5f.; Schaffer et al. 2017; Ifenthaler/Schumacher 2016, 178). Die automatisierte Empfehlung von Lernteams kann Peer Learning anregen. Lernende können sich dabei gegenseitig als Lernpartner/innen (ähnlicher Lernfortschritt) oder Lernexpert/inn/en (größerer Lernfortschritt) unterstützen (vgl. Ifenthaler/Schumacher 2016, 179). Selbstreguliertes Lernen kann durch Aufzeigen eines Lernverlaufs sowie zielgerichteten Empfehlungen, was sich an der Art und Weise des Lernprozesses verändern sollte, gefördert werden (vgl. Winne 2017, 246). Darauf können automatisierte Interventionsimpulse, beispielsweise zur Unterstützung der Selbstkontrolle, folgen (vgl. Lodge et al. 2019, 49ff.).

3.2 Lehrende

Aus Lehrendenperspektive liegt das Potenzial von Learning Analytics u. a. in der Unterstützung zur Lernerfolgsprognose und Reflexion des eigenen Lehrhandelns begründet:

- Prognose von Lernerfolgen: Die Aggregation von Daten ermöglicht es, Lernerfolge zu prognostizieren, bewährte Lernpfade offenzulegen und frühzeitig abbruchgefährdete Lernende zu identifizieren und zu unterstützen (vgl. Tulodziecki 2020, 376; Mandausch/Meinhard 2018, 25; Grandl et al. 2017, 5f.; Schaffer et al. 2017; Ifenthaler/Schumacher 2016, 178).

- Reflexion und Evaluation: Reflexionsimpulse betreffen sowohl Lernende als auch Lernende (vgl. Dyckhoff 2014, 16; Greller/Drachsler 2012, 47). Ein didaktisches Potenzial liegt in einer zusätzlich gewinnenden Perspektive auf Lehr-Lernprozesse. Dies erlaubt Lehrenden ihre eigene Lehre zu reflektieren und gegebenenfalls anzupassen (vgl. Mandausch/Meinhard 2018, 31; Ifenthaler/Schumacher 2016, 179).

- Adaptive Lehre: Learning Analytics ermöglichen eine zielgerichtete und an den Lernfortschritt angepasste Unterstützung von Lehr-Lernprozessen (vgl. Mandausch/Meinhard 2018, 31; Ifenthaler/Schumacher 2016, 179). Lehrende erhalten Ansatzpunkte zur Anpassung ihres Kursdesigns an die Bedürfnisse der Lernenden und können darüber hinaus gleichzeitig in Echtzeit auf auftretende Lernschwierigkeiten eingehen bzw. darauf Rücksicht nehmen (vgl. Ifenthaler/Schumacher 2016, 179).

- Modellierung von Lernanlässen: Learning Analytics können zur Modellierung und Anpassung von Lernaktivitäten eingesetzt werden, beispielweise zur präventiven Vorbeugung von Lernschwierigkeiten (vgl. Greller/Drachsler 2012, 47). Durch Visualisieren des tatsächlichen Lernstandes können Lehrende Lernanlässe und Lernmaterialien adaptieren sowie zusätzliche Materialien zur Verfügung stellen (vgl. Ifenthaler/Schumacher 2016, 177; Johnson et al. 2013, 19; Greller/Drachsler 2012, 52).

Mit Hilfe von Learning Analytics kann eine bisher ungenutzte und nicht zu erfassende Perspektive auf Lehren und Lernen gelegt werden. Damit kann Wissen über Lernende, deren Lernprobleme und Bedürfnisse generiert werden, noch bevor eine Leistungsbeurteilung stattgefunden hat. So kann via Learning Analytics die Diagnosekompetenz der Lehrenden erweitert werden. Hierdurch können schnellere, gezieltere, sowie auf den Lernbedarf abgestimmte didaktische Interventionen gesetzt werden, als es bisher möglich war (vgl. Grandl et al. 2017; Groißböck/Buchner 2016; Greller/Drachsler 2012, 52). Darüber hinaus ermöglicht der Einsatz sozialer Netzwerkanalysen, als eine Analysemethode von Learning Analytics, eine Integration von Beziehungen unter Lernenden in die Datenanalyse. Dies ermöglicht beispielsweise das Identifizieren isolierter Lernender oder das Erforschen der Auswirkungen von Gruppenstrukturen auf ein mehr oder weniger effektives Lernverhalten (vgl. Buckingham Shum 2012, 6).

3.3 Inhalt und Learning Design

Die Inhaltskomponente des didaktischen Dreiecks wird insbesondere durch adaptive Lernumgebungen und Möglichkeiten zur Optimierung des Learning Designs tangiert:

- Adaptive Lernumgebungen: Unter Rückgriff auf datengestütztes Wissen über Lehr-Lernprozesse können Lehrende u. a. ihre Lehre sowie das Lernmanagementsystem weiter optimieren, den Bedürfnissen der Lernenden anpassen, das verwendete Lernmaterial angleichen oder zusätzliche Lernaktivitäten zur Verfügung stellen (vgl. Ifenthaler/Schumacher 2016, 177, 180; Johnson et al. 2013, 19).

- Evaluation und Optimierung des Learning Designs: Ein Vergleich didaktisch geplanter Lern-Lernarrangements mit dem tatsächlichen Nutzungsverhalten dieser Lernanlässe ermöglicht das Hinterfragen didaktischer Interventionen. Ausgehend davon kann eine datengestützte Weiterentwicklung didaktischer Konzepte, Lehr-Lernarrangements und des Learning Designs erfolgen (vgl. Riedel/Adelberg/Schulze-Achatz 2019, 43; Seiler et al. 2018, 595f.; Rienties et al. 2017).

Die dargestellten Ansatzpunkte von Learning Analytics zur didaktischen Anreicherung von Lehr-Lernprozessen erheben nicht den Anspruch der Vollständigkeit und bieten die Ausgangsbasis für weiterführende Interventionen. Die Entfaltung des Potenzials bedingt allerdings zum einen darauf basierende Implikationen seitens Lehrender sowie zum anderen die Nutzung des offengelegten Informationsspektrums seitens der Lernenden. Darin liegt u. a. ein Zugewinn für Lernende: diese erhalten mehr Möglichkeiten ihre Lernprozesse eigenmächtig zu steuern. Sind sich Lernende daraus wiederum um etwaige Unterstützungserfordernisse bewusst, kann dies eine Passung von Inhalten, Lehre und Lernendenbedürfnissen (Learning Design) begünstigen. Der Ausschöpfungsgrad des gezeigten theoretisch vorhandenen didaktischen Potenzials von Learning Analytics wird allerdings je nach fokussierter Zielsetzung des Einsatzes von Learning Analytics und dem konkreten Anwendungsszenario variieren. Ein Nutzen von Learning Analytics für den Hochschulkontext kann sich neben der individuellen Ebene der Lernenden und Lehrenden sowie Kursebene auch auf den institutionellen oder politischen Bereich erstrecken und vielfältiger Natur sein (siehe dazu beispielsweise Ifenthaler/Schumacher 2016). So wie Einsatzszenarien von Learning Analytics einen dynamischen Betrachtungszugang benötigen, so erfordert auch dessen Output die Einnahme einer holistischen bzw. systemischen Perspektive. Sollen Lernprozesse durch den Einsatz von beispielsweise Echtzeit-Feedback gefördert werden, bedingt dies zum einen die Möglichkeit auf den aktuellen Lernstand zugreifen zu können. Dies setzt wiederum eine formative Leistungsbeurteilung voraus und stellt gleichzeitig dennoch nur einen Ausschnitt innerhalb der digitalen Lernumgebung dar. Weitere Einflussfaktoren können innerhalb und außerhalb des digitalen und nicht digitalen Lernkontextes liegen. Eine isolierte Wirkungszuschreibung von Learning Analytics ist hier denkbar schwierig.

4 Anwendungsszenario: Learning Analytics im Masterstudium Wirtschaftspädagogik

Im folgenden Kapitel erfolgt die Darstellung des praktischen Einsatzes von Learning Analytics in der forschungsgeleiteten Lehre in einer fachdidaktischen Lehrveranstaltung (Proseminar) im Masterstudium der Wirtschaftspädagogik an der Universität Graz. Neben der Skizzierung der Implementierung von Learning Analytics liegt der Fokus in der Erläuterung des Forschungsdesigns zur Annäherung an das didaktische Potenzial von Learning Analytics. Die didaktische Ausrichtung ist von einer kognitivistischen und gemäßigt-konstruktivistischen Perspektive geprägt und intendiert die Initiierung einer digital angereicherten Lernumgebung, in welcher teils selbstgesteuertes Lernen stattfinden kann.

4.1 Implementierung von Learning Analytics

Eine eigens eingerichtete Instanz des Lernmanagementsystems Moodle bildet dabei die Grundlage für die Implementierung von Learning Analytics im Masterstudium Wirtschaftspädagogik. Die zugrunde liegende fachdidaktische Lehrveranstaltung ist so gestaltet, dass Lernende selbständig und aktiv zum Lernen angeregt werden. Dazu werden den Lernenden abwechslungsreiche und medial vielfältige Lernaktivitäten zur Verfügung gestellt, wie beispielsweise ein lehrveranstaltungsbegleitendes interaktives Moodle-Book mit H5P-Lernvideos, Links, elektronisch verfügbaren Skripten und implementierten Lernanlässen wie unterschiedliche Quiz samt Lösungen, Lektionen, Foren oder Glossare. Die Lernaktivitäten werden in verpflichtende und freiwillige Lernanlässe gesplittet, wobei die freiwilligen Lernanlässe im Sinne eines Gamification-Ansatzes als Level-Up-Struktur abgebildet werden. Lernende können somit auf ein zusätzliches Lernangebot zurückgreifen und Erfahrungspunkte sammeln, welche sich auf die Erhöhung ihrer individuellen Lernlevel auswirken. Die Aktivitäten werden dabei an Voraussetzungen geknüpft (Abschluss bestimmter Kursaktivitäten) und sukzessive automatisiert freigeschaltet. Sämtlich gestaltete Lernanlässe basieren in erster Linie auf kognitivistisch und gemäßigt konstruktivistisch Überlegungen. Zur Übertragung in das Lernmanagementsystem fließen weiters mediendidaktische Überlegungen mit ein. Diesbezüglich wird der Anspruch verfolgt, das technisch Mögliche zwar umzusetzen – insbesondere zur Sicherstellung eines ausreichenden Datenkorpus für die Anwendung von Learning Analytics – pädagogisch-didaktische Bestrebungen liefern jedoch den Ausgangspunkt.

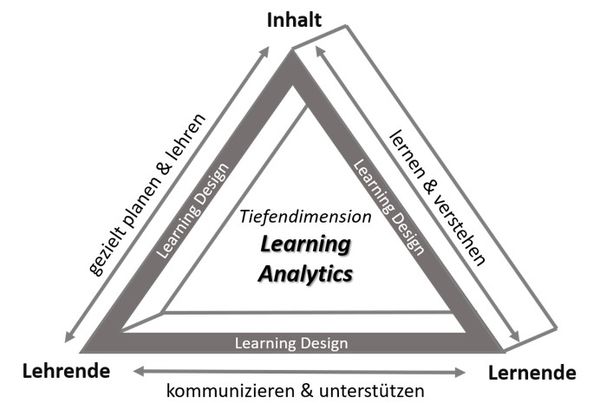

Der Fokus der Datengenerierung aus dem Lernmanagementsystem Moodle liegt auf der Analyse und Darstellung von Metadaten, beispielsweise der Zugriffe auf oder Anzahl der (noch nicht) genutzten Lernaktivitäten (z. B. Anzahl der Klicks auf Lernquizze je User-ID) sowie der im Lernmanagementsystem verbrachten Zeit (z. B. Datum und Zeit der Zugriffe auf Lernquizze je User-ID). Diese Metadaten werden mit dem formativen Bewertungssystem (erreichte Punkte je Lernaktivität) verknüpft und mittels eines in Moodle integrierten Dashboards in Echtzeit visualisiert (zu Dashboards vgl. Leitner/Ebner 2017; Buckingham Shum/Ferguson 2012, 4). Lehrende und Lernende verfügen über jeweils getrennte Dashboards, die gegenseitig nicht einsehbar sind.

In Abbildung 3 wird das Dashboard für Lernende veranschaulicht. Auf Grundlage der vorhandenen Datenbasis (Aktivitäten des Lernmanagementsystems) werden die verfügbaren Daten zur Unterstützung (selbstgesteuerter) Lernprozesse visualisiert. Das Dashboard dient zum einen als Monitoring-Instrument: im Score-Tachometer wird der bisher erreichte Punktestand aus gelösten Aufgabenstellungen des/der Studierenden (blau) im Vergleich zu den Peers Durchschnitt-Score (grau) sowie bester Score (schwarz) dargestellt. Zum anderen stellt die Timeline ein Planungselement dar: es werden die dazugehörigen Ereignisse (z. B. synchrone Kurseinheiten) sowie Lernaktivitäten (z. B. Quizze, Lektionen, Peer-Review) eines ganzen Semesters aufgezeigt. Beide Visualisierungskomponenten sollen insbesondere auch eine motivationale Funktion erfüllen sowie die Selbsteinschätzung Lernender in Bezug auf ihr eigenes Lernen fördern. Learning Analytics liefern Lernenden über das Dashboard Informationen zu eigenen Lernprozessen. Es liegt allerdings an den Lernenden selbst, diese nach eigenem Ermessen und Bedürfnissen auch zu nutzen.

Abbildung 3: Lernenden-Dashboard, entwickelt von der Technischen Universität Graz

Abbildung 3: Lernenden-Dashboard, entwickelt von der Technischen Universität Graz

Das Dashboard für Lehrende bezieht sich auf die Kursebene, d. h. es visualisiert die aggregierten Daten aller Lernenden und enthält, analog zu den Elementen des Lernenden-Dashboards, Anzeigen über die verfügbaren Lernaktivitäten und deren Absolvierungsgrad. Darüber hinaus umfasst das Lehrenden-Dashboard eine aggregierte Häufigkeitsanzeige der Zugriffe auf unterschiedliche Lernanlässe sowie die verbrachte Zeit der Lernenden auf der Lernplattform. Um eine Unterstützungswirkung von Lehr-Lernprozessen herbeizuführen, liegt die Herausforderung nun darin, diese visualisierten Ergebnisse in einen pädagogisch sinnvollen Kontext zu setzen (vgl. Lockyer/Heathcote/Dawson 2013, 1455).

4.2 Forschungsdesign

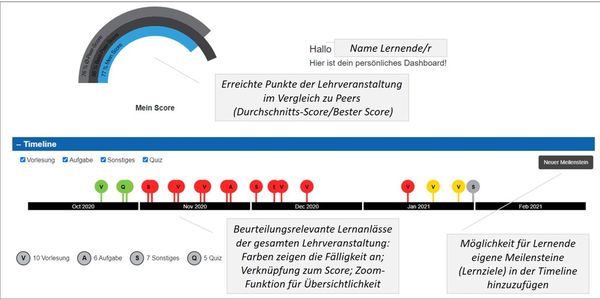

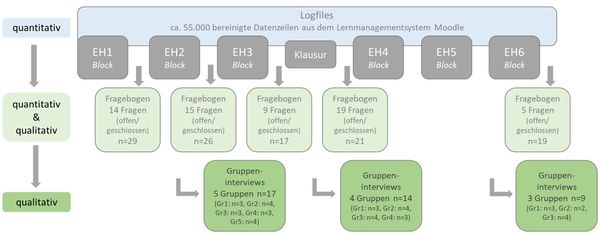

Um die in Logfiles protokollierten Lernaktivitäten des Lernmanagementsystems in einen pädagogisch stimmigen Kontext zu setzen und um aus dem Einsatz von Learning Analytics didaktische Implikationen ableiten zu können, wurde auf einen Mixed-Methods-Ansatz in einem sequenziell kombinierten quantitativ-qualitativ-vertiefenden Design (vgl. Kuckartz 2014, 30; 77-78) zurückgegriffen. Dazu wurden im Laufe der ersten Erhebungsperiode (t1; Sommersemester 2020) zwischen den geblockten Lehrveranstaltungseinheiten mehrmals hintereinander quantitative und qualitative Erhebungen durchgeführt. Zur Beantwortung der leitenden Fragestellung nach dem didaktischen Potenzial von Learning Analytics wird in der Begleitforschung unter den Studierenden insbesondere deren subjektiv wahrgenommener Nutzen aus der Implementierung von Learning Analytics für die Verbesserung ihrer Lernprozesse erhoben. In Abbildung 4 wird das Erhebungsdesign zu t1 dargestellt.

Abbildung 4: Erhebungsdesign zu Erhebungsperiode t1

Abbildung 4: Erhebungsdesign zu Erhebungsperiode t1

Auf die Ergebnisse einer beginnenden quantitativen Logfileanalyse (deskriptivstatistische Betrachtung) erfolgten direkt im Lernmanagementsystem eingebettete Fragebogenerhebungen mit quantitativen und qualitativen Items, um die Erkenntnisse der Logfileanalyse einerseits abzugleichen und andererseits zu vertiefen. Die Ergebnisse der Fragebögen wiederum flossen in die Gestaltung der Interviewleitleitfaden für die Gruppeninterviews ein. Die Abfolge von quantitativer, quantitativ-qualitativer und qualitativ vertiefender Erhebung wiederholt sich im Verlauf der Erhebungsperiode t1 mehrmals.

Im Wintersemester 2020/21 (Erhebungsperiode t2) wurde das Lehrveranstaltungsdesign aufgrund der zu t1 erlangten Einsichten angepasst. Das grundsätzliche Forschungsdesign (siehe Abbildung 5) wurde in der Erhebungsperiode t2 beibehalten, indem beginnend bei einer quantitativen Auswertung das quantitativ-qualitativ-vertiefende Design anschließt und dieser Zyklus mehrmals wiederholt wird. Die zwei Lehrenden sind gleichsam als Forschende in das übergeordnete Projekt Learning Analytics involviert, um Rückschlüsse auf einen didaktischen Mehrwert ziehen zu können sowie Voraussetzungen, Grenzen und ein erforderliches Mindestmaß an technischer Versiertheit auszuloten. Die Perspektive der Lehrenden fließt als Erfahrungsbericht in das Datenmaterial ein.

Abbildung 5: Erhebungsdesign zu Erhebungsperiode t2

Abbildung 5: Erhebungsdesign zu Erhebungsperiode t2

Damit kann zur Beantwortung der Fragestellung auf einen umfassenden Datenkorpus aus der nachfolgend dargestellten vierstufigen Analyse zurückgegriffen werden.

- Die erhobenen und pseudonymisierten Logfiles wurden mit deskriptivstatistischen Methoden strukturiert, erkundet und beschrieben (vgl. Döring/Bortz 2016a, 621; Döring/Bortz 2016b, 352). Auf dieser Datengrundlage folgte ein sich wiederholendes kombiniert quantitativ und qualitatives Vertiefungsdesign.

- Der quantitative schriftliche Befragungsteil hatte die Funktion, die Daten der Logfilebetrachtung mit der Wahrnehmung der Lernenden abzugleichen. Dazu wurden Items, die den Merkmalen der Logfiles entsprachen, eingesetzt und mit den Merkmalsausprägungen als Antwortalternativen versehen.

- Die teilstrukturierte qualitative schriftliche Befragung erfolgte unter Einsatz halbstandardisierter Teilfragebögen. Die Fragen bezogen sich auf die Dimensionen des allgemeinen Learning Designs, der Level-Up-Struktur (freiwillige Lernanlässe), der verpflichtenden Lernanlässen und der Lernvideos. Ab der Erhebungsperiode t2 wurde zur teilweisen Visualisierung der mit Learning Analytics ausgewerteten Daten zusätzlich ein Dashboard im Lernmanagementsystem integriert, worauf dann weitere Items in den Befragungen gerichtet waren.

- Die Interviewleitfäden zu den ergänzend durchgeführten qualitativen halbstrukturierten Gruppeninterviews (vgl. Döring/Bortz 2016b, 365ff.) wurden aus den Ergebnissen der schriftlichen quantitativen und qualitativen Befragung abgeleitet.

Das Datenmaterial besteht demzufolge aus Logfiles, den Daten des sequenziell quantitativ-qualitativ-vertiefenden Designs (Fragbögen, Gruppeninterviews) und den Erfahrungsberichten der Lehrenden. In der Erhebungsperiode t1 waren 35 Teilnehmer/innen in den Kurs eingeschrieben (zwei Lehrveranstaltungsgruppen), welche bis Ende des Semesters in Summe 55.172 an bereinigten Datenzeilen über das Lernmanagementsystem Moodle generierten. Zusätzlich wurden fünf Fragebögen mit offenen und geschlossenen Fragen direkt in Moodle implementiert, welche von durchschnittlich 22 Lernenden ausgefüllt wurden. In Summe wurden 112 ausgefüllte Fragebögen ausgewertet. Ergänzend wurden über die Erhebungsperiode verteilt zwölf qualitative Gruppeninterviews von je ca. 20 Minuten mit einer Gruppengröße von durchschnittlich drei Lernenden geführt. In der zweiten Erhebungsperiode wurde der Kurs mit einer Lehrveranstaltungsgruppe mit insgesamt 21 Studierenden geführt, welche 32.747 bereinigte Datenzeilen produziert haben. Weiters wurden sechs Fragebogenerhebungen mit qualitativen und quantitativen Elementen von durchschnittlich 17 Lernenden ausgefüllt (105 Fragebögen) und drei qualitative Gruppeninterviews mit je drei Studierenden für je ca. 20 Minuten geführt.

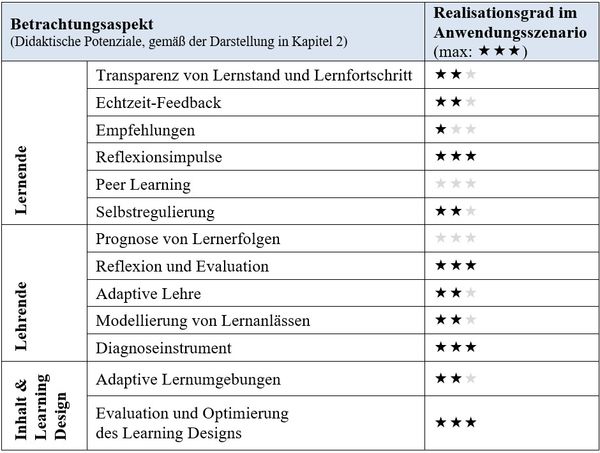

Zur Datenauswertung des quantitativen Datenmaterials (Logfiles und quantitative Fragebogenelemente) wurden Visualisierungstechniken der Deskriptivstatistik eingesetzt. Dabei können lediglich ein Nutzungsverhalten sowie Korrelationen aufgezeigt werden. Eine dahinterliegende Kausalität kann damit nicht begründet werden. Aus diesem Grund wurde diese Datenbasis mit einem quantitativen und qualitativen Vertiefungsdesign ergänzt, um das Nutzungsverhalten annähernd in ein Lernverhalten innerhalb eines digitalen Lehr-Lernsettings überführen zu können. Die Gruppeninterviews in den jeweiligen Erhebungsperioden wurden vollinhaltlich transkribiert und zusammen mit den Fragebögen und den Erfahrungsberichten der Lehrenden einer qualitativen Inhaltsanalyse nach Mayring unterzogen (vgl. Mayring 2015). Dazu erfolgt eine kombiniert deduktiv-induktive Kategorienbildung. Ausgehend von der forschungsgeleitenden Perspektive, das didaktische Potenzial von Learning Analytics auszuloten, bildet das aus der Literatur abgeleitete theoretische Potenzial (vgl. Ausführungen in Kapitel 3) den Referenzrahmen. Die Ebenen des Learning-Analytics-Dreiecks, (1) Lernende, (2) Lehrende sowie (3) Inhalt und die vereinende Dimension Learning Design, bilden den ersten Schritt der Klassifikation des didaktischen Potenzials. Zur Spezifikation des Konstruktes des didaktischen Potenzials erfolgt dabei in direkter Verbindung zur Literaturbetrachtung eine deduktive Kategorienbildung (Tabelle 1).

|

Lernende |

Lehrende |

Inhalt & |

|

|

|

Tabelle 1: Kategorien der inhaltsanalytischen Auswertung

Das Kategoriensystem besteht dabei zum einen aus der in Tabelle 1 dargestellten Ebenen bzw. Kategorien sowie zum anderen aus den Kategoriendefinitionen und Ausprägungsstufen. Die Definition der Kategorien erfolgt anhand eines viergeteilten Schemas (vgl. Kuckartz 2018, 40). Neben der (1) inhaltlichen Beschreibung wird zwischen (2) der Anwendung jeder Kategorie, (3) der Beispiele für die Anwendung sowie (4) der Abgrenzung zu anderen Kategorien differenziert. Diese Kategorienbeschreibung wurde im ersten Schritt deduktiv aus der Literatur gewonnen und anschließend induktiv am Datenmaterial ergänzt, präzisiert bzw. modifiziert. Für die angelegten theoretischen Kategorien werden drei Ausprägungsgrade (ordinales Skalenniveau) definiert, anhand derer eine Zuordnung erfolgt: (1) ausgeprägt, (2) wenig ausgeprägt, (3) nicht ausgeprägt. Diese Ausprägungsgrade dienen als Realisationsgrad im konkreten Anwendungsszenario. Da sich die grundlegenden Elemente des Unterrichts, Lehr-Lernprozesse, Lernangebot sowie Learning Design, wechselseitig beeinflussen, sind infolgedessen die Kategorien des didaktischen Potenzials jedoch nicht trennscharf voneinander abgrenzbar.

Die qualitative Begleitforschung zeigt eine Diskrepanz zwischen dem aus Logdaten sichtbar gemachten Nutzungsverhalten in einem Lernmanagementsystem und einem tatsächlichem Lernverhalten auf, was wiederum die Relevanz menschlicher Urteilskraft im Bildungskontext unterstreicht (vgl. dazu auch die Ausführungen von Büching et al. 2019). Während dieses sequenzielle Mixed-Methods-Design zur Interpretation der Nutzungsdaten aus dem Lernmanagementsystem beigetragen hat, waren die Ergebnisse daraus wiederum Ausgangspunkt für die Ableitung didaktischer Implikationen und Interventionen.

4.3 Vorläufige Ergebnisse und didaktische Implikationen des Einsatzes von Learning Analytics

Obgleich aus der reinen Betrachtung der Metadaten des Lernmanagementsystems nur eine Beschreibung eines Nutzungsverhaltens innerhalb des betrachteten digitalen Lehr-Lernsettings erfolgen kann und dies nicht als Lernverhalten missinterpretiert werden sollte, wird die Aufmerksamkeit auf bestimmte Aspekte gelenkt, welche unter Umständen ohne eine ‚Datenperspektive‘ keine Beachtung erhalten würden. So kann zwar nicht davon ausgegangen werden, dass beispielsweise die verbrachte Zeit in einem Lernmanagementsystem mit Lernzeit gleichzusetzen ist oder, dass hohe Zugriffszahlen effektive Lernanlässe kennzeichnen (vgl. Ifenthaler/Schumacher 2016, 181). Allerdings kann eine Abweichung vom intendierten und angenommen Nutzungsverhalten Anhaltspunkte für weitere Untersuchungen oder didaktische Interventionen liefern. Folglich können beispielsweise als selbsterklärend geltende Lernanlässe durch eine tatsächliche hohe/niedrige Nutzung hinterfragt werden. Infolgedessen können gegebenenfalls Lernschwierigkeiten aufgedeckt werden. Darüber hinaus können Klickzahlen ebenso auch Hinweise auf eine erforderliche Umgestaltung oder Erleichterung der Navigation innerhalb eines Learning Designs geben.

Den Referenzrahmen zur Herausarbeitung der didaktischen Implikationen aus dem Einsatz von Learning Analytics im gegenständlichen Anwendungsszenario bilden die inhaltsanalytischen Auswertungen anhand des entwickelten Kategoriensystems (vgl. Tabelle 1 in Kapitel 4.2). Die Kategorien stellen die Betrachtungsaspekte des didaktischen Potenzials dar. Die Auswertungen des Datenmaterials haben der jeweiligen Kategorie eine Ausprägung zugewiesen, die nachfolgend als Realisationsgrad bezeichnet wird. Dieser soll anzeigen, inwieweit die angeführten Potenziale bereits realisiert wurden oder wo noch Entwicklungsspielraum im Rahmen des Szenarios besteht.

Tabelle 2: Realisationsgrad des didaktischen Potenzials im Anwendungsszenario

Tabelle 2: Realisationsgrad des didaktischen Potenzials im Anwendungsszenario

Der in Tabelle 2 angegebene Realisationsgrad bezieht sich lediglich auf das konkrete Anwendungsszenario im Masterstudium Wirtschaftspädagogik und erhebt keinen Anspruch auf Allgemeingültigkeit. In Bezug auf die Transparenz des Lernstandes und -fortschrittes wurde dieser durch den Einsatz des Dashboards gewährleistet. Entwicklungsbedarf besteht noch in einer feingliedrigeren Darstellung des Lernstandes, beispielsweise untergliedert nach Beurteilungsaspekten. Das Echtzeit-Feedback richtet sich im konkreten Fall vor allem auf die inhaltliche Sofort-Rückmeldung von Lernanlässen und auf das Dashboard, welches eine wichtige Feedback-Funktion in Bezug auf Lernstand, Lernfortschritt und dem Aufzeigen weiterer Lernschritte darstellt. Potenzial liegt hier noch in der Erweiterung der Feedbackebenen um die Prozessebene und die Ebene der Selbstregulation (vgl. Hattie 2018, 135f.). Empfehlungen an die Lernenden richten sich in diesem Anwendungsfall nur auf das Setzen nächster Lernaktivitäten, jedoch ohne inhaltliche Differenzierung. Der Einbezug von Inhaltsdaten, als Ergänzung zu den verwendeten Metadaten, könnte konkretere Empfehlungen, z. B. in Hinblick auf bedarfsgerechte Lernmaterialien, möglich machen.

Ein Mehrwert durch den Einsatz von Learning Analytics, vor allem in Verbindung mit dem Dashboard, zeigt sich im Initiieren von Reflexionsimpulsen für Lernende (u. a. in Bezug auf Lernverhalten und Wissenslücken) sowie Lehrende (beispielweise hinsichtlich des Lehrverhaltens oder der Nutzung von angebotenen Lernaktivitäten) und als Instrument zur Erweiterung der Diagnosekompetenz der Lehrenden (durch z. B. den Abgleich von tatsächlichem und intendiertem Leistungsniveau der Lernenden oder das Offenlegen von Verständnisschwierigkeiten in Echtzeit). Darüber hinaus können Learning Analytics zur Evaluation und Optimierung des Learning Designs sowie zur Unterstützung von selbstreguliertem Lernen dienen. Selbstreguliertes Lernen kann beispielsweise durch die Visualisierung des Lernstandes und Lernfortschrittes, im Vergleich zu Peers, unterstützt werden. Lernende werden dadurch angeregt, über ihr Lernverhalten und künftig notwendige Lernschritte nachzudenken. Das Setzen eigener Lernziele kann dies zusätzlich begünstigen. Neben positiven Auswirkungen auf die Regulation des Verarbeitungsmodus und des Lernprozesses, kann das Aufzeigen von Lernfortschritten oder das Setzen von Zielen weiters Einfluss auf die Regulation des Selbst, als Komponente selbstregulierten Lernens, ausüben (zu den Komponenten selbstregulierten Lernens vgl. z. B. Götz/Nett 2017, 154f.). Das Erreichen eigener Lernziele oder gesteckter Lernerfolge kann demzufolge eine positive emotionale und motivationale Einstellung der Lernenden herbeiführen. Gleichzeitig erhalten Lernende unmittelbar die Möglichkeit, selbstbestimmt weitere Lernaktivitäten zu setzen, um sich zu verbessern. Darüber hinaus liefert eine Lernstands- und Lernfortschrittsbegleitung Impulse zur Entwicklung einer in Hinblick auf Selbstregulierung lernrelevanten Haltung. Lernende lernen zum einen ihren Lernprozess kontrollieren, und damit steuern, zu können und zum anderen üben sie sich zugleich in der Selbsteinschätzung ihrer Lernprozesse.

In Bezug auf Möglichkeiten in Richtung adaptives Lehren, Modellierung von Lernanlässen oder auch der Adaption von Lernumgebungen und damit zur Optimierung von Learning Design stiftet der Einsatz von Learning Analytics einen Nutzen im Offenlegen diverser Verbesserungspotenziale. Hierdurch wird ermöglicht, auf aufgeworfene Fragen der Lernanlässe in Echtzeit zu reagieren und die Lehre just-in-time an die Bedürfnisse der Lernenden anpassen zu können. Gleichzeitig können Lernmaterialien gezielter überarbeitet, wie auch das Learning Design bedarfsgerecht adaptiert werden. Ein Anregen von Peer Learning wie auch die Prognose von Lernerfolgen durch Learning Analytics war in diesem konkreten Anwendungsszenario noch nicht intendiert und wurde daher auch nicht realisiert.

Der Einsatz von Learning Analytics erfolgt im konkreten Anwendungsfall ohne die Aufstellung bestimmter Hypothesen und soll auf explorativer Ebene das didaktische Potenzial in einem konkreten Anwendungsszenario ausloten. Zu beachten ist, dass in diesem Anwendungsszenario nur ein geringes Spektrum an möglichen Learning-Analytics-Anwendungen eingesetzt wird und daher ein realisiertes Potenzial auch nur in diesem Kontext einzustufen ist. Auch vollziehen Lernende außerhalb eines Lernmanagementsystems formelle, nicht formelle und informelle Lernleistungen und werden dabei u. a. vom Lernumfeld beeinflusst, weshalb die ausschließliche Fokussierung auf Daten aus Lernmanagementsystemen Verzerrungen unterliegen kann (vgl. Slade/Prinsloo 2013; Johnson/Adams/Cummins 2012, 27). Um das volle Potenzial von Learning Analytics ausschöpfen zu können, wäre mitunter ein größtmöglicher Einbezug des Lernkontextes, abseits der digitalen Lernumgebung, von Lernenden notwendig. Dazu gehören beispielsweise individuelle Merkmale der Lernenden, wie deren Vorwissen, Interessen, Lernstrategien, Wissen über die Nutzung und Präferenzen digitaler sowie sozialer Medien und auch physische Einflussfaktoren, wie gesundheitliche, emotionale oder motivationale Aspekte (vgl. Ifenthaler/Widanapathirana 2014, 223). Dennoch liegt es auf der Hand, dass sich auch dann nicht der gesamte Lernkontext von Lernenden in digitalen Daten abbilden lässt. Dies setzt eine vorsichtige Nutzung der Daten voraus bzw. schränkt deren Interpretationsbreite und -tiefe ein, was die Übersetzung dieser Daten in pädagogisch sinnvolle Interventionen erschwert (vgl. Mandausch/Meinhard 2018, 29f.). Das alleinige Nutzen eines Lernmanagementsystems kann nicht automatisch mit Lernen gleichgesetzt werden. Die Anzahl der Klicks oder die verbrachte Zeit im Lernmanagementsystem sind kein geeigneter Indikator für Lernleistungen (vgl. Ifenthaler/Schumacher 2016, 181). Nach wie vor offen bei der Interpretation der Daten bleibt weiters – sofern überhaupt Rückschlüsse aus den Daten gezogen werden können – welche Rückschlüsse wertvoll zur Weitergabe an Lernende sind und welchen Einfluss diese auf das Lernverhalten haben (vgl. Atif et al. 2013). Darüber hinaus liefern Learning Analytics zwar Ansatzpunkte zur Gestaltung eines didaktischen Designs eines digitalen Lehr-Lernsettings. Dieses didaktische Design ist jedoch gleichzeitig eine der zentralen Determinanten für den Erfolg von Learning Analytics (vgl. Gašević/Dawson/Siemens 2015).

Fazit: Die wesentlichen Erkenntnisse durch den Einsatz von Learning Analytics liegen in einem Beitrag zur Unterstützung einer lernendenzentrierten Ausrichtung der Lehre, im Schaffen individualisierter Lernerlebnisse, im Personalisieren von Lernumgebungen und dem Ermöglichen von selbstgesteuertem Lernen in technologiegestützten Lehr-Lernsettings. Abschließend lässt sich festhalten, dass ein zusätzlicher Ansatzpunkt von Learning Analytics im Offenlegen von Fehlern liegt. Dahingehend können Learning Analytics der Entwicklung von Fehlerkompetenz zuträglich sein und zur Weiterentwicklung einer konstruktiv nutzenstiftenden Fehlerkultur im Bildungskontext beitragen.

5 Abschließende Darstellung und Ausblick

Der Einsatz von Learning Analytics im Bildungskontext bringt neue Möglichkeiten zur Erforschung von Lehren und Lernen hervor. Gleichzeitig zeigen sich jedoch auch Schwierigkeiten bei der Messung und Interpretation des Konstrukts ‚Lernen‘ aus Datenspuren. Reagieren Lehrende und/oder Lernende auf Visualisierungen aus der Anwendung von Learning Analytics, verändern sie dadurch gleichzeitig das System; es wird dynamisch, reflexiv (vgl. Knight/Buckingham Shum 2017, 18). Diese Schwierigkeit verdeutlicht jedoch zugleich auch die diesbezügliche Eignung von Learning Analytics. Learning Analytics sind demzufolge in der Lage, den dynamischen Prozesscharakter von Lernen aufzugreifen, um daraus wiederum bewusst Lernprozesse zu initiieren und infolgedessen die Reflexions- und Handlungsfähigkeit der Lernenden zu unterstützen. Learning Analytics können dabei als Bindeglied zwischen wissenschaftlichen Erkenntnissen der allgemeinen und beruflichen Lehr-Lernforschung sowie einer evidenzbasierten pädagogischen Praxis dienen. Ausgehend von einer kognitivistischen und gemäßigt-konstruktivistischen Perspektive wird Lernen als aktiver Prozess des Wissenserwerbs verstanden, der mehr oder minder stark durch Instruktionen angestoßen wird (vgl. Slepcevic-Zach/Tafner 2019, 192ff.). In Ergänzung zur Lehrperson stellen Learning Analytics hier ein zusätzliches Instrument zur Initiierung von Lernprozessen dar – und folglich auch zur Ergänzung handlungsorientierter Unterrichtsformen. Damit kann einer v. a. in der beruflichen Bildung geforderten Handlungskompetenz (vgl. Slepcevic-Zach/Tafner 2019, 206) entgegengekommen und zugleich der Lerntransfer unterstützt werden. Der Mehrwert der Anwendung von Learning Analytics für ein Lernen im Berufskontext kann in der Offenlegung und Nachvollziehbarkeit formeller, nicht formeller als auch informeller Lernprozesse liegen, um in Folge diese individuellen Lernaktivitäten wiederum besser mit organisatorischen Lernzielen in Einklang zu bringen (vgl. beispielsweise die Ausführungen zu Professional Learning Analytics von Littlejohn 2017).

Neben einem intendierten Nutzen für die Anspruchsgruppen des Bildungssektors muss beim Einsatz von Learning Analytics jedoch auch ein kritischer Blick auf wichtige Aspekte wie Datenschutz, Datenverantwortung und Datenethik erfolgen (vgl. Alexander et al. 2019, 16; Grandl et al. 2017, 9ff.). Außerdem ist ein bewusster und vor allem verantwortungsvoller Umgang in Hinblick auf mögliche positive und auch negative Auswirkungen von Dateninterpretationen entscheidend (vgl. Mandausch/Meinhard 2018, 28; Groißböck/Buchner 2016). In diesem Kontext steht die noch unzureichende Ausrichtung des Forschungsfokus von Learning Analytics auf die pädagogisch-didaktische Perspektive (vgl. Dyckhoff et al. 2012). Die Interpretation der Ergebnisse stellt jedoch nicht die alleinige Crux dar, sondern das Ableiten eines daraus entstehenden Handlungsbedarfes, um eine Verbesserung von Lehr-Lernprozessen herbeizuführen (vgl. Mandausch/Meinhard 2018, 29). In diesem Zusammenhang zeigt sich wiederum die Notwendigkeit, die noch unzureichende Digital Literacy und Data Literacy von Lehrenden und Lernenden voranzutreiben (vgl. Witt de 2020, VII).

Der in diesem Beitrag präsentierte Forschungszugang stellt eine erste explorative Annäherung an das didaktische Potenzial von Learning Analytics dar, welche bislang lediglich für das in Kapitel 4 skizzierte Anwendungsszenario Gültigkeit aufweist. Weitere mögliche Zugänge zur Erforschung von Nutzungspotenzialen aus dem Einsatz von Learning Analytics könnten die empirische Wirkungsforschung mit dem Aptitude-Treatment-Interaction-Ansatz (ATI) oder alternativ der Design-Based-Research-Ansatz (DBR) sein. Während der Fokus bei ATI auf der Untersuchung der Wirksamkeit eines bereits entwickelten Lehr-Lernsettings liegt, und davon ausgegangen wird, dass Verbesserungen von Lernprozessen durch eine optimale Passung von Lehrmethoden und Voraussetzungen der Lernenden erreicht werden können (vgl. Euler/Wilbers 2020, 435ff.), wird mit DBR explorativ untersucht, wie ein bestimmtes Ziel in einem bestimmten Kontext durch iterative Interventionen erreicht werden kann (vgl. Aprea 2007, 153ff.). Als Ergebnis können Gestaltungsprinzipien oder didaktische Lehr-Lernkonzepte für einen pädagogisch sinnstiftenden Einsatz von Learning Analytics resultieren, um damit von Big Data zu aussagekräftigen Daten zu kommen. Hauptanliegen zukünftiger Forschungsarbeiten im Bereich von Learning Analytics können damit die Untersuchung des praktischen Anwendungsbereiches im pädagogisch-didaktischen Kontext sein, wobei eine Verschränkung von technischer, pädagogischer und rechtlich-ethischer Perspektive anzustreben ist.

Ein Mehrwert dieser Learning-Analytics-Betrachtung impliziert die Überlegung, dass zwar der Pädagogik das Primat gegenüber der Technik (vgl. Handke 2020, 12; Zierer 2020, 9), z. B. im Rahmen didaktischer Erstüberlegungen, einzuräumen ist, dass jedoch erst durch den Einsatz von Technik eine Offenlegung verborgener lehr-lernrelevanter Aspekte ermöglicht wird. Gleichzeitig soll diese technische Betrachtung nicht entkoppelt von Fragstellungen von Recht und Ethik vorgenommen werden. Die Anwendung von Learning Analytics im Masterstudium der Wirtschaftspädagogik soll einen Impuls geben für die – der vorliegenden Ausgabe titelgebende – Didaktisierung des Digitalen. Die im Rahmen dieses Beitrages beschriebene Implementierung soll Möglichkeiten für den sinnstiftenden Einsatz digitaler Technologien zur Unterstützung von Lehr-Lernprozessen in der Lehrer/innen/bildung aufzeigen, um damit auch die Lehrer/innen/bildung für die digitale Transformation anschlussfähig zu machen.

Danksagung

Die vorliegende Publikation entstand im Rahmen des Projektes Learning Analytics: Auswirkungen von Datenanalysen auf den Lernerfolg unter Zusammenarbeit des Zentrums für Digitales Lehren und Lernen, des Instituts für Wirtschaftspädagogik (beide Karl-Franzens-Universität Graz) sowie der Organisationseinheit für Lehr- und Lerntechnologien (Technische Universität Graz). Die Autor/inn/en bedanken sich für die Förderung des Projektes im Rahmen der Ausschreibung ‚Auswirkungen der Digitalisierung auf die berufliche Kompetenzentwicklung‘ des Zukunftsfonds Steiermark (www.zukunftsfonds.steiermark.at/).

Literatur

Alexander, B./Ashford-Rowe, K./Barajas-Murphy, N./Dobbin, G./Knott, J./McCormack, M./Pomerantz, J./Seilhamer, R./Weber, N. (2019): Educause Horizon Report. 2019 Higher Education Edition. Louisville.

Aprea, C. (2007): Aufgabenorientiertes Coaching in Designprozessen. Fallstudien zur Planung wirtschaftsberuflicher Lernumgebungen. München.

Arnold, P./Kilian, L./Thillosen, A. M./Zimmer, G. M. (2018): Handbuch E-Learning. Lehren und Lernen mit digitalen Medien. Bielefeld.

Atif, A./Richards, D./Bilgin, A./Marrone, M. (2013): Learning Analytics in Higher Education: A Summary of Tools and Approaches. In: Gosper, M./Hedberg, J./Carter, H. (Hrsg.): Electric Dreams. Proceedings of the 2013 ASCILITE Conference in Sydney, 68-72.

Azcona, D./Hsiao, I-H./Smeaton, A. F. (2019): Detecting students-at-risk in computer programming classes with learning analytics from students’ digital footprints. In: User Modeling and User-Adapted Interaction, 29, H. 4, 759-788.

Baumert, J./Klieme, E./Neubrand, M./Prenzel, M./Schiefele, U./Schneider, W./Stanat, P./Tillmann, K.-J./Weiß, M. (2001): PISA 2000. Wiesbaden.

Bienkowski, M./Feng, M./Means, B. (2014): Enhancing Teaching and Learning Through Educational Data Mining and Learning Analytics: An Issue Brief.

Büching, C./Mah, D.-K./Otto, S./Paulicke, P./Hartman, E. A. (2019): Learning Analytics an Hochschulen. In: Wittpahl, V. (Hrsg.): Künstliche Intelligenz. Berlin, 142-160.

Buckingham Shum, S. (2012): Learning Analytics. Policy Brief, November 2012, UNESCO Institute for Information Technologies in Education. Online: https://iite.unesco.org/pics/publications/en/files/3214711.pdf (16.3.2021).

Buckingham Shum, S./Ferguson, R. (2012): Social learning analytics. In: Educational Technology and Society, 15, H. 3, 3-26.

Chatti, M. A./Dyckhoff, A. L./Schroeder, U./Thüs, H. (2012a): A reference model for learning analytics. In: International Journal of Technology Enhanced Learning, 4, H. 5-6, 318-331.

Chatti, M. A./Dyckhoff, A. L./Schroeder, U./Thüs, H. (2012b): Forschungsfeld Learning Analytics. Learning Analytics Research Challenges. In: i-com, 11, H. 1, 22-25.

Döring, N./Bortz, J. (2016a): Datenanalyse. In: Döring, N./Bortz, J. (Hrsg.): Forschungsmethoden und Evaluation in den Sozial- und Humanwissenschaften. Berlin, 597-784.

Döring, N./Bortz, J. (2016b): Datenerhebung. In: Döring, N./Bortz, J. (Hrsg.): Forschungsmethoden und Evaluation in den Sozial- und Humanwissenschaften. Berlin, 321-577.

Dubs, R. (2009): Lehrerverhalten. Ein Beitrag zur Interaktion von Lehrenden und Lernenden im Unterricht. Stuttgart.

Dyckhoff, A. L. (2014): Action Research and Learning Analytics in Higher Education. Dissertation, RWTH Aachen.

Dyckhoff, A. L./Zielke, D./Bültmann, M./Chatti, M. A./Schroeder, U. (2012): Design and implementation of a learning analytics toolkit for teachers. In: Educational Technology and Society, 15, H. 3, 58-76.

Ebner, M./Ebner, M. (2018): Learning Analytics an Schulen – Hintergrund und Beispiele. In: Medienimpulse, 56, H. 1, 1-28.

Ebner, M./Neuhold, B./Schön, M. (2013): Learning Analytics – wie Datenanalyse helfen kann, das Lernen gezielt zu verbessern. In: Wilbers, K./Hohenstein, A. (Hrsg.): Handbuch E-Learning-Expertenwissen aus Wissenschaft und Praxis - Strategien, Instrumente, Fallstudien. Köln, 1-20.

Ebner, M./Taraghi, B./Saranti, A./Schön, S. (2015): From the field. Seven features of smart learning analytics – lessons learned from four years of research with learning analytics. In: eLearning Papers, H. 40, 1-5.

Euler, D./Seufert, S./Wilbers, K. (2006): eLearning in der Berufsbildung. In: Arnold, R./Lipsmeier, A. (Hrsg.): Handbuch der Berufsbildung. Wiesbaden, 432-450.

Euler, D./Wilbers, K. (2020): Berufsbildung in digitalen Lernumgebungen. In: Arnold, R./Lipsmeier, A./Rohs, M. (Hrsg.): Handbuch Berufsbildung. Wiesbaden, 427-438.

Ferguson, R. (2012): Learning Analytics: Drivers, Developments and Challenges. In: International Journal of Technology Enhanced Learning, 4, H. 5/6, 304-317.

Gašević, D./Dawson, S./Siemens, G. (2015): Let’s not forget: Learning analytics are about learning. In: TechTrends, 59, H. 1, 64-71.

Gerholz, K.-H./Dorman, M. (2017): Ausbildung 4.0: Didaktische Gestaltung der betrieblich-beruflichen Ausbildung in Zeiten der digitalen Transformation. In: bwp@ Berufs- und Wirtschaftspädagogik – online, H. 32, 1-22. Online: http://www.bwpat.de/ausgabe32/gerholz_dormann_bwpat32.pdf (16.3.2021).

Gloerfeld, C. (2020): Auswirkungen von Digitalisierung auf Lehr- und Lernprozesse. Wiesbaden.

Götz, T./Nett, U. E. (2017): Selbstreguliertes Lernen. In: Goetz, T. (Hrsg.): Emotion, Motivation und selbstreguliertes Lernen. Paderborn, 144-184.

Grandl, M./Taraghi, B./Ebner, M./Leitner, P./Ebner, M. (2017): Learning Analytics. In: Handbuch E-Learning: Expertenwissen aus Wissenschaft und Praxis - Strategien, Instrumente, Fallstudien, H. 72, 1-16.

Greller, W./Drachsler, H. (2012): Translating Learning into Numbers: A Generic Framework for Learning Analytics. In: Journal of Educational Technology & Society, 15, H. 3, 42-57.

Grillenberger, A./Romeike, R. (2019): Vorstudie Hochschulübergreifende Konzepte zum Erwerb von 21st century skills am Beispiel von Data Literacy. Berlin.

Groißböck, P./Buchner, J. (2016): Learning Analytics: Die Verwendung von Daten in der Schule. Vortrag im Rahmen der Privacy Week. Wien.

Handke, J. (2020): Handbuch Hochschullehre Digital. Leitfaden für eine moderne und mediengerechte Lehre. Baden-Baden.

Hattie, J. (2018): Lernen sichtbar machen für Lehrpersonen. Baltmannsweiler.

Hmyzo, E./Muzzu, A. (2020): Technologie im Rechnungswesen – Wenn die Maschine besser und schneller bucht. In: Berding, F./Jahncke, H./Slopinski, A. (Hrsg.): Moderner Rechnungswesenunterricht 2020. Wiesbaden, 99-113.

Höfler, E./Kopp, M. (2018): MOOCs und Mobile Learning. In: Witt de, Claudia/Gloerfeld, Christina (Hrsg.): Handbuch Mobile Learning. Wiesbaden, 543-564.

Ifenthaler, D. (2012): Determining the effectiveness of prompts for self-regulated learning in problem-solving scenarios. In: International Forum of Educational Technology & Society, 15, 38-52.

Ifenthaler, D./Schumacher, C. (2016): Learning Analytics im Hochschulkontext. In: WiSt – Wirtschaftswissenschaftliches Studium, 45, H. 4, 176-181.

Ifenthaler, D./Widanapathirana, C. (2014): Development and Validation of a Learning Analytics Framework: Two Case Studies Using Support Vector Machines. In: Technology, Knowledge and Learning, 19, H. 1-2, 221-240.

Jank, W./Meyer, H. (2014): Didaktische Modelle. Berlin.

Janschitz, G./Monitzer, S./Slepcevic-Zach, P./Dreisiebner, G./Stock, M./Kopp, M. (2019): Analyse und Förderung des Erwerbs digitaler Kompetenzen von Studierenden (DiKoS). In: bwp@ Spezial AT-2: Beiträge zum 13. Österreichischen Wirtschafspädagogik-Kongress, 1-23. Online: http://www.bwpat.de/wipaed-at2/janschitz_etal_wipaed-at_2019.pdf (16.3.2021).

Johnson, L./Adams, S./Cummins, M. (2012): NMC Horizon Report: 2012 Higher Education Edition. Austin.

Johnson, L./Adams Becker, S./Cummins, M./Freeman, A./Ifenthaler, D./Vardaxis, N.(2013): Technology Outlook, Australian Tertiary Education 2013-2018. An NMC Horizon project regional analysis. Austin.

Khalil, M./Ebner, M. (2015): Learning Analytics: Principles and Constraints. In: Proceedings of World Conference on Educational Multimedia, Hypermedia and Telecommunication. Chesapeake, 1326-1336.

Knight, S./Buckingham Shum, S. (2017): Theory and Learning Analytics. In: Lang, C./Siemens, G./Wise, A./Gasevic, D. (Hrsg.): Handbook of Learning Analytics, 17-22.

Koh, W./Choi, J. (2016): A pedagogic method helps to create an actionable policy from big data through a PDCA cycle. In: International Journal of Technology, Policy and Management, 16, H. 1, 4-17.

Krause, M. (2020): Soziale Lernplattformen für Hochschulen. Kooperation, Privatheit und Forschungspotenziale am Beispiel von Campus.UP. In: heiEDUCATION Journal, H. 5, 57-80.

Kuckartz, U. (2014): Mixed Methods. Methodologie, Forschungsdesigns und Analyseverfahren. Wiesbaden.

Kuckartz, U. (2018): Qualitative Inhaltsanalyse. Methoden, Praxis, Computerunterstützung. Weinheim.

Leitner, P./Khalil, M./Ebner, M. (2017): Learning Analytics in Higher Education—A Literature Review. In: Peña-Ayala, A. (Hrsg.): Learning Analytics: Fundaments, Applications, and Trends. Cham, 1-23.

Leitner, P./Ebner, M. (2017): Development of a dashboard for learning analytics in higher education. In: Zaphiris, P./Ioannou, A. (Hrsg.): Learning and Collaboration Technologies. Technology in Education. 4th International Conference, LCT 2017. Cham, 293-301.

Leitner, P./Ebner, M./Ammenwerth, E./Andergassen, M./Csanyi, G./Gröblinger, O./Kopp, M./Reichl, F./Schmid, M./Steinbacher, H.-P./Handle-Pfeiffer, D./Zitek, A./Zöserl, E./Zwiauer, C. (2019): Learning Analytics: Einsatz an österreichischen Hochschulen. Online: https://www.fnma.at/content/download/1896/8814 (16.3.2021).

Lester, J./Klein, C./Rangwala, H./Johri, A. (2017): Learning Analytics in Higher Education. In: ASHE Higher Education Report, 43, H. 5, 9-135.

Littlejohn, A. (2017): Learning and Work: Professional Learning Analytics. In: Lang, C./Siemens, G./Wise, A./Gasevic, D. (Hrsg.): Handbook of Learning Analytics, 269-277.

Lockyer, L./Heathcote, E./Dawson, S. (2013): Informing Pedagogical Action. In: American Behavioral Scientist, 57, H. 10, 1439-1459.